В каждой тематике найдутся десятки базовых запросов, например, «бульдозер», «трактор» и так далее. Как раз из фраз с базовыми запросами и будет состоять ваша рекламная кампания («купить бульдозер», «продать трактор»).

Как собрать базовые запросы

- Зайдите как минимум на 30 сайтов конкурентов: выпишите все слова и фразы из вашей тематики.

- Изучите потребности потенциальных клиентов. Подумайте, что обычно ищут в интернете ваши клиенты. И почему бы по их популярным запросам не показать ваше объявление?

- Соберите синонимы для базовых запросов. Например, пуховик-тёплая зимняя одежда.

- Соберите жаргонизмы и сленговые выражения. Для этого изучите профильные форумы, где общается ваша аудитория.

- Соберите транслиты. Например, вместе «купить стиральную машину Bosch» ищут «купить стиральную машину бош».

- Соберите похожие на ваш запрос из правой колонки Wordstat (https://wordstat.yandex.ru/).

- Соберите подсказки из Яндекса и Google. Когда вы вводите запрос в поисковую строку, то видите подсказки или похожие запросы.

- Соберите запросы, по которым рекламируются ваши конкуренты, с помощью специального сервиса advse.ru.

Как собрать рекламные запросы

- Вручную с помощью Wordstat.

- В автоматическом режиме с помощью специальных программ, например, KeyCollector, СловоЁб или Магадан.

Как сгенерировать рекламные запросы

Возьмём тему авиабилетов. Допустим, у вас есть 5 базовых запросов («чартер», «отпуск», «авиабилеты», «тур», «улететь») и сотня городов, по которым вы хотите рекламироваться, то есть вам нужно перемножить 5 запросов на 100 городов. Для перемножения удобнее всего использовать специальный сервис по генерации подобных запросов - py7.ru/tools/text/.

Как сделать чистку семантического ядра

Чтобы не потратить деньги на нецелевые запросы, соберите список минус-слов или мусорных запросов, по которым ваши объявления не покажутся в Яндекс.Директ. Задать минус-слова можно легко, например, в специальной программе KeyCollector, тем самым увеличив CTR.

Брендовая семантика

В идеале процесс работает так:

2) Собираете семантику по маркерным запросам откуда угодно: от Wordstat до поисковых подсказок.

Неважно, что вы используете при сборе. У всех сервисов разное качество, но принцип один: на входе вы вводите маркерный запрос, а программа выдает расширения, которые содержат фразу.

Задача, которую приходится решать вручную – определить те самые маркеры (базисы). Каждый из них отражает собственный спрос, ключевые фразы, расширения и охват. Для этого необходимо хотя бы минимальное знакомство с ассортиментом.

Когда речь идет о брендовой семантике, понятно, как искать маркеры. У бренда есть, как правило, русское или английское написание, названия серий, моделей. При этом важно учесть все ошибочные и синонимичные написания. О других случаях с примерами будет далее в статье.

3) Получаете десятки-сотни тысяч запросов, чистите их от «мусора» и получаете две группы: нужные запросы и минус-слова.

Рассмотрим брендовую семантику на примере интернет-магазина туристического оборудования и товаров «Моя планета».

У магазина около 70-80 брендов, один из них – Stanley. Это и инструменты, и мебель, и посуда, и много другого. Нет смысла собирать все расширения от слова stanley, иначе будет очень много «мусора». Поэтому оставляем запросы из 2-3 слов:

Чаще всего лучше брать трехсловники или двухсловники, в некоторых специфических случаях допустимы однословники.

Термосы – самый популярный товар, у него 3 написания названия бренда – станлей, стенли, stanley, – и есть маркеры по сериям: stanley mountain, стенли классик.

Чем больше базисов, тем шире охват. У нас получается 70 видов товаров, по каждому – 20-50 базисов. Общий объем «хвоста» – несколько сотен тысяч расширенных запросов. Они могут пересекаться, но частично: как правило, процент пересечения невысокий.

В итоге вы получаете 100% охват, но тратите очень много времени на обработку данных. Чтобы ускорить процесс, часто используют способ перемножения запросов в скрипте-перемножалке.

Для брендового семантического ядра такой метод ускоряет работу. Но что делать, когда вы предлагаете услуги на высококонкурентном рынке?

Семантика по сложным услугам

В этой ситуации – более неочевидные запросы, которые можно выявить только с помощью глубокого анализа.

Пример – «дизельный» автосервис, клиент агентства MOAB.

Исходные данные: прежний подрядчик перемножал стандартные названия услуг на транзакционные слова типа «цены», «купите» и прочие. В итоге получались базисы «ремонт форсунок», «ремонт ТНВД» и иже с ними.

Этот подход дает самые банальные формулировки. Точная копия ключа, перестановка слов, разные падежи и словоформы – не вариант для проявления креатива. Все – и подрядчики, и клиенты – мыслят одинаково, используют однотипные формулировки и транзакционные слова. Запросы «от фонаря» быстро перегреваются.

Результат – потеря охвата и, как следствие, недостаточная загруженность сервиса, так как нет показов по неочевидным запросам. Их и невозможно получить простым перемножением.

Парадокс ситуации в том, что трафика немного (до 10 посетителей в сутки), но аукцион жуткий (до 40 рублей за клик). Даже сервису с огромной материальной базой, низкой себестоимостью и большим потоком клиентов практически невозможно окупить ставки по конкретному ключу.

По результатам анализа мы нашли дополнительные базисы (указана частотность по Москве):

Большинство из них и для самого заказчика были откровением: он не подозревал, что потенциальные клиенты могут ТАК формулировать поиск, хотя давно работает в этой сфере.

Эти запросы далеко не очевидные и для конкурентов, а потому неперегретые. Прогнозный суточный трафик – около 400-500 пользователей, суммарно для всех систем. Средняя цена по ним гораздо ниже, чем по фразам типа «ремонт форсунок».

Как систематизировать, если маркеры не привязаны к бренду и содержат размытый спрос? Что ищет целевая аудитория – этого не придумать спонтанно и не услышать от заказчика.

Одна проблема генерирует неизвестный большой массив запросов: дизель дымит черным, сизым, белым, не работает, стучит, гремит и т.д. Ваша задача – разбить этот массив на кластеры, чтобы разграничить на конечное количество потребностей.

Переменные спроса

В случае с брендом «якорь» спроса – само название. Товары Stanley не могут называться как-то иначе, это в любом случае нечто со словом «Stanley».

Для сложной услуги спрос распадается на несколько составляющих (переменных). Невозможно сформулировать проблему без одного из них:

- Проблема с агрегатом – пользователь знает или предполагает, что сломалось (форсунки, ТНВД, плунжера). И дальше начинается полет фантазий – «форсунка стучит», «форсунка гремит», «форсунка дымит» и т.д.

- Проблема с машиной – он не знает, что сломалось и не хочет это выяснять, просто пишет название марки своей машины (Scania, Камаз, Man). В нашем случае бензиновые машины – не наш профиль, отбираем только те, которые работают на дизеле;

- Через топливо – человек не указывает машину или агрегат, а указывает тип топлива – «дизельный двигатель», «дизель», «дизельный автомобиль ремонт»;

- Через проявление проблемы («дымит», «не едет»). Например, черный дым – характерная дизельная проблема, здесь не нужно уточнять, бензин это или дизель;

- Через код ошибки по автосканеру («ошибка 1235», «ошибка 0489»).

С большой вероятностью человек, у которого сломался дизель, употребит хотя бы одно из значений этих переменных в запросе. Это «якорь», вокруг которого вертится спрос по проблеме.

Рекомендация: чтобы разбивать запросы на переменные и подбирать их значения, нужно представлять, как потенциальная аудитория говорит о проблемах. Для этого полезно изучать сайты конкурентов, тематические форумы, сообщества и т.д.

Чем это отличается от перемножения

Представьте, есть гора, внутри которой – золотые слитки, которые вам надо добыть. Стандартный способ – выкопать шахту в этой горе и собрать золото, которое попадется на пути исследования.

Другой вариант – вы срываете гору экскаватором и отвозите на горнообогатительный комбинат. Он более трудозатратный и требует больше компетенций, но зато из всей массы пород вы соберете всё золото.

По аналогии с этим мы берем весь спрос по запросу «дизель», «дизельный» и прорабатываем все расширения в глубину в Wordstat. Затем по каждому собираем поисковые подсказки. По полученному массиву пробиваем частотность, удаляем дубли и получаем итоговый объем запросов.

Допустим, у нас получилось 100 тысяч. Что дальше с ними делать? Отбираем нужные фразы.

Для этого загоняем каждый массив в «Анализ Групп» в Key Collector. Применяем частотный словарь запросов. В нем необходимо поставить группировку по фразам и залить во вкладку ключевые слова.

Что получаем:

На этом этапе не надо чистить массив от минус-слов и т.д. Нужно просто просмотреть частотный словарь и выявить двухсловники, которые явно указывают на авторемонт.

В чем преимущества? Часто употребляемые группы запросов привязаны к наиболее популярным проблемам. Программа сортирует группы по количеству входящих в них слов. Вы просматриваете все результаты и выявляете группы, которые подходят под вашу проблему.

Вы получаете всё, что вообще можно в этой тематике собрать. При этом нормально, если у вас исходно 100 тысяч запросов со словом «дизель» и только 10 тысяч после анализа.

Подобную работу проделываете со всеми значениями переменных.

Семантика для точного спроса

Для автотехцентра «ЯпиМоторс» агентство MOAB составило один из самых больших семантических планов за свою историю. Специфика клиента: ему необходимо обеспечить точный трафик.

Заказчик четко обозначил исходные условия: есть точный перечень работ (300 штук), которые он выполняет, и список марок (70 штук), с которыми работает.

На первом этапе мы искали всевозможные названия по списку работ:

- Ремонт тормозов – ремонт тормозной системы, замена тормозной системы, не работают тормоза и т.д.

- Ремонт двигателя – ремонт ДВС, замена ДВС, ремонт движка и т.д.

Японские названия сложные, их часто пишут с ошибками. В итоге 70 заданных марок / моделей превратились в 270 строк различных вариантов написания латиницей и кириллицей.

Рынок большой, поэтому компания не претендовала на весь целиком. Логично: один автосервис не может обслуживать всю Москву. Его цель – небольшая часть этого спроса, но максимально горячая, и за минимальные деньги. Поэтому мы определили запросы, которые уже сейчас имеют неотложную потребность.

Если пользователь пишет в поиске «черный дым дизель», он может еще неделю ездить на дымящем автомобиле, прежде чем тот совсем накроется. А «ремонт ходовой цена» – прямо сейчас может сконвертироваться.

Перемножаем 450 работ на 270 моделей и получаем список маркеров, по которому снимаем частотность.

Около 5 тысяч базисов показали ненулевую частотность и «хвост» расширений в 50 тысяч. В отличие от ядра по дизелю, в котором много «мусора», это содержит минимальное число минус-слов, практически все запросы целевые.

Семантика для фидов

Зачем её собирать

Семантика для фидов обеспечивает достоверный минус-файл и чистоту трафика.

Стандартного списка минус-слов недостаточно. В лучшем случае они закрывают 30-40% реальных минус-слов. В каждой тематике также есть запросы, которые содержат характерные слова и делают сам запрос нецелевым, нерелевантным для вас. Поэтому нужно собирать минус-слова для фидов на основе реальных запросов.

Пример – запросы по автозапчастям Bosch. Это массив в несколько сотен тысяч. Из него мы выделили те, которые содержат цифры – это запросы товарные, таких получилось 20-30 тысяч. Мы составили из них частотный словарь, чтобы найти группы с нерелевантным спросом. Важно брать реальные фразы по конкретному бренду.

Это дает более точный файл минус-слов, на основе которого можно запретить нецелевые показы. В итоге по России средняя цена клика составила 7-10 рублей, а цена заявки – 60-70 рублей. Мы добились высокой конверсии, так как привлекали только трафик, близкий к покупке.

Подводные камни рекламы на фидах

Допустим, у вас 10 тысяч автозапчастей. В процессе важно проверить, нет ли среди артикулов двойные значения. Он может означать как товар, так и ГОСТ, инструкцию, которые не имеют отношения к вашей тематике. Или товар абсолютно из другой области.

Как это проверить? Берете список артикулов и пробиваете по ним частотность. Также вручную выявляете артикулы с двойным значением. По ним уточняете семантику – добавляете название бренда или уточняющие слова, чтобы исключить показы по нецелевому охвату.

Достаточно ли в объявление добавить артикул или нужно «%артикул + %купить (или другое транзакционное слово) »

Второй вариант не дает дополнительного трафика, но вы можете напрямую контролировать позицию объявления не только по запросу артикула, но и по запросу «%артикул + %купить» через подключение биддера.

В идеале процесс работает так:

2) Собираете семантику по маркерным запросам откуда угодно: от Wordstat до поисковых подсказок.

Неважно, что вы используете при сборе. У всех сервисов разное качество, но принцип один: на входе вы вводите маркерный запрос, а программа выдает расширения, которые содержат фразу.

Задача, которую приходится решать вручную - определить те самые маркеры (базисы). Каждый из них отражает собственный спрос, ключевые фразы, расширения и охват. Для этого необходимо хотя бы минимальное знакомство с ассортиментом.

Когда речь идет о брендовой семантике, понятно, как искать маркеры. У бренда есть, как правило, русское или английское написание, названия серий, моделей. При этом важно учесть все ошибочные и синонимичные написания. О других случаях с примерами будет далее в статье.

3) Получаете десятки-сотни тысяч запросов, чистите их от «мусора» и получаете две группы: нужные запросы и минус-слова.

Рассмотрим брендовую семантику на примере интернет-магазина туристического оборудования и товаров «Моя планета».

У магазина около 70-80 брендов, один из них - Stanley. Это и инструменты, и мебель, и посуда, и много другого. Нет смысла собирать все расширения от слова stanley, иначе будет очень много «мусора». Поэтому оставляем запросы из 2-3 слов:

Чаще всего лучше брать трехсловники или двухсловники, в некоторых специфических случаях допустимы однословники.

Термосы - самый популярный товар, у него 3 написания названия бренда - станлей, стенли, stanley, - и есть маркеры по сериям: stanley mountain, стенли классик.

Чем больше базисов, тем шире охват. У нас получается 70 видов товаров, по каждому - 20-50 базисов. Общий объем «хвоста» - несколько сотен тысяч расширенных запросов. Они могут пересекаться, но частично: как правило, процент пересечения невысокий.

В итоге вы получаете 100% охват, но тратите очень много времени на обработку данных. Чтобы ускорить процесс, часто используют способ перемножения запросов в скрипте-перемножалке.

Для брендового семантического ядра такой метод ускоряет работу. Но что делать, когда вы предлагаете услуги на высококонкурентном рынке?

Семантика по сложным услугам

В этой ситуации - более неочевидные запросы, которые можно выявить только с помощью глубокого анализа.

Пример - «дизельный» автосервис, клиент агентства MOAB.

Исходные данные: прежний подрядчик перемножал стандартные названия услуг на транзакционные слова типа «цены», «купите» и прочие. В итоге получались базисы «ремонт форсунок», «ремонт ТНВД» и иже с ними.

Этот подход дает самые банальные формулировки. Точная копия ключа, перестановка слов, разные падежи и словоформы - не вариант для проявления креатива. Все - и подрядчики, и клиенты - мыслят одинаково, используют однотипные формулировки и транзакционные слова. Запросы «от фонаря» быстро перегреваются.

Результат - потеря охвата и, как следствие, недостаточная загруженность сервиса, так как нет показов по неочевидным запросам. Их и невозможно получить простым перемножением.

Парадокс ситуации в том, что трафика немного (до 10 посетителей в сутки), но аукцион жуткий (до 40 рублей за клик). Даже сервису с огромной материальной базой, низкой себестоимостью и большим потоком клиентов практически невозможно окупить ставки по конкретному ключу.

По результатам анализа мы нашли дополнительные базисы (указана частотность по Москве):

Большинство из них и для самого заказчика были откровением: он не подозревал, что потенциальные клиенты могут ТАК формулировать поиск, хотя давно работает в этой сфере.

Эти запросы далеко не очевидные и для конкурентов, а потому неперегретые. Прогнозный суточный трафик - около 400-500 пользователей, суммарно для всех систем. Средняя цена по ним гораздо ниже, чем по фразам типа «ремонт форсунок».

Как систематизировать, если маркеры не привязаны к бренду и содержат размытый спрос? Что ищет целевая аудитория - этого не придумать спонтанно и не услышать от заказчика.

Одна проблема генерирует неизвестный большой массив запросов: дизель дымит черным, сизым, белым, не работает, стучит, гремит и т.д. Ваша задача - разбить этот массив на кластеры, чтобы разграничить на конечное количество потребностей.

Переменные спроса

В случае с брендом «якорь» спроса - само название. Товары Stanley не могут называться как-то иначе, это в любом случае нечто со словом «Stanley».

Для сложной услуги спрос распадается на несколько составляющих (переменных). Невозможно сформулировать проблему без одного из них:

- Проблема с агрегатом - пользователь знает или предполагает, что сломалось (форсунки, ТНВД, плунжера). И дальше начинается полет фантазий - «форсунка стучит», «форсунка гремит», «форсунка дымит» и т.д.

- Проблема с машиной - он не знает, что сломалось и не хочет это выяснять, просто пишет название марки своей машины (Scania, Камаз, Man). В нашем случае бензиновые машины - не наш профиль, отбираем только те, которые работают на дизеле;

- Через топливо - человек не указывает машину или агрегат, а указывает тип топлива - «дизельный двигатель», «дизель», «дизельный автомобиль ремонт»;

- Через проявление проблемы («дымит», «не едет»). Например, черный дым - характерная дизельная проблема, здесь не нужно уточнять, бензин это или дизель;

- Через код ошибки по автосканеру («ошибка 1235», «ошибка 0489»).

С большой вероятностью человек, у которого сломался дизель, употребит хотя бы одно из значений этих переменных в запросе. Это «якорь», вокруг которого вертится спрос по проблеме.

Рекомендация: чтобы разбивать запросы на переменные и подбирать их значения, нужно представлять, как потенциальная аудитория говорит о проблемах. Для этого полезно изучать сайты конкурентов, тематические форумы, сообщества и т.д.

Чем это отличается от перемножения

Представьте, есть гора, внутри которой - золотые слитки, которые вам надо добыть. Стандартный способ - выкопать шахту в этой горе и собрать золото, которое попадется на пути исследования.

Другой вариант - вы срываете гору экскаватором и отвозите на горнообогатительный комбинат. Он более трудозатратный и требует больше компетенций, но зато из всей массы пород вы соберете всё золото.

По аналогии с этим мы берем весь спрос по запросу «дизель», «дизельный» и прорабатываем все расширения в глубину в Wordstat. Затем по каждому собираем поисковые подсказки. По полученному массиву пробиваем частотность, удаляем дубли и получаем итоговый объем запросов.

Допустим, у нас получилось 100 тысяч. Что дальше с ними делать? Отбираем нужные фразы.

Для этого загоняем каждый массив в «Анализ Групп» в Key Collector. Применяем частотный словарь запросов. В нем необходимо поставить группировку по фразам и залить во вкладку ключевые слова.

Что получаем:

Это запросы, про которые не расскажет клиент. Так практически никто не делает, поэтому и конкуренция по такой семантике минимальная.

На этом этапе не надо чистить массив от минус-слов и т.д. Нужно просто просмотреть частотный словарь и выявить двухсловники, которые явно указывают на авторемонт.

В чем преимущества? Часто употребляемые группы запросов привязаны к наиболее популярным проблемам. Программа сортирует группы по количеству входящих в них слов. Вы просматриваете все результаты и выявляете группы, которые подходят под вашу проблему.

Вы получаете всё, что вообще можно в этой тематике собрать. При этом нормально, если у вас исходно 100 тысяч запросов со словом «дизель» и только 10 тысяч после анализа.

Подобную работу проделываете со всеми значениями переменных.

Семантика для точного спроса

Для автотехцентра «ЯпиМоторс» агентство MOAB составило один из самых больших семантических планов за свою историю. Специфика клиента: ему необходимо обеспечить точный трафик.

Заказчик четко обозначил исходные условия: есть точный перечень работ (300 штук), которые он выполняет, и список марок (70 штук), с которыми работает.

На первом этапе мы искали всевозможные названия по списку работ:

- Ремонт тормозов - ремонт тормозной системы, замена тормозной системы, не работают тормоза и т.д.

- Ремонт двигателя - ремонт ДВС, замена ДВС, ремонт движка и т.д.

Японские названия сложные, их часто пишут с ошибками. В итоге 70 заданных марок / моделей превратились в 270 строк различных вариантов написания латиницей и кириллицей.

Рынок большой, поэтому компания не претендовала на весь целиком. Логично: один автосервис не может обслуживать всю Москву. Его цель - небольшая часть этого спроса, но максимально горячая, и за минимальные деньги. Поэтому мы определили запросы, которые уже сейчас имеют неотложную потребность.

Если пользователь пишет в поиске «черный дым дизель», он может еще неделю ездить на дымящем автомобиле, прежде чем тот совсем накроется. А «ремонт ходовой цена» - прямо сейчас может сконвертироваться.

Перемножаем 450 работ на 270 моделей и получаем список маркеров, по которому снимаем частотность.

Около 5 тысяч базисов показали ненулевую частотность и «хвост» расширений в 50 тысяч. В отличие от ядра по дизелю, в котором много «мусора», это содержит минимальное число минус-слов, практически все запросы целевые.

Семантика для фидов

Зачем её собирать

Семантика для фидов обеспечивает достоверный минус-файл и чистоту трафика.

Стандартного списка минус-слов недостаточно. В лучшем случае они закрывают 30-40% реальных минус-слов. В каждой тематике также есть запросы, которые содержат характерные слова и делают сам запрос нецелевым, нерелевантным для вас. Поэтому нужно собирать минус-слова для фидов на основе реальных запросов.

Пример - запросы по автозапчастям Bosch. Это массив в несколько сотен тысяч. Из него мы выделили те, которые содержат цифры - это запросы товарные, таких получилось 20-30 тысяч. Мы составили из них частотный словарь, чтобы найти группы с нерелевантным спросом. Важно брать реальные фразы по конкретному бренду.

Это дает более точный файл минус-слов, на основе которого можно запретить нецелевые показы. В итоге по России средняя цена клика составила 7-10 рублей, а цена заявки - 60-70 рублей. Мы добились высокой конверсии, так как привлекали только трафик, близкий к покупке.

Подводные камни рекламы на фидах

Это «фэйковые» артикулы и названия товаров.

Допустим, у вас 10 тысяч автозапчастей. В процессе важно проверить, нет ли среди артикулов двойные значения. Он может означать как товар, так и ГОСТ, инструкцию, которые не имеют отношения к вашей тематике. Или товар абсолютно из другой области.

Как это проверить? Берете список артикулов и пробиваете по ним частотность. Также вручную выявляете артикулы с двойным значением. По ним уточняете семантику - добавляете название бренда или уточняющие слова, чтобы исключить показы по нецелевому охвату.

Достаточно ли в объявление добавить артикул или нужно «%артикул + %купить (или другое транзакционное слово) »

Второй вариант не дает дополнительного трафика, но вы можете напрямую контролировать позицию объявления не только по запросу артикула, но и по запросу «%артикул + %купить» через подключение биддера.

Так было до недавнего времени. На очень больших товарных фидах не хватало баллов, чтобы загрузить много ключевых слов, и приходилось от этого отказываться.

Вывод: нет смысла размножать семантику по фидам. Достаточно добавить одно самое широкое название артикула или индекс товара.

Что делать со статусом «мало показов»

В первую очередь смотрите не что и как выпало, а изменился ли трафик. Если нет, переживать не стоит. Значит, эти объявления не генерировали трафик.

Если заметно снизился - не плюс-минус 10% погрешность, а больше, - то нужно разбираться: скорее всего, ошибки в кластеризации по кампании, подборе семантики. Хотя, применительно к фидам, такое маловероятно.

SEO или контекст - что лучше

Как планировать маркетинг

В современных условиях нужно окупаться на любых каналах. Принципиальной идеологической разницы между ними быть не должно.

Как это выглядит при нормальном планировании? Сначала мы определяемся с нишей, делаем HTML-макет сайта, движок, и тут же начинаем составлять семантику. При этом важно, чтобы структура зависела не от каталога и не от вашего видения разделов, а от семантики. То, что люди ищут чаще всего, разместите на видных местах.

После того, как собрали семантику и определились со структурой, создаем и наполняем контентом сайт.

Рекомендация: сначала контекст, потом SEO. Можно почистить и сгруппировать семантику и запустить контекст, чтобы бизнес зарабатывал деньги. Пусть не очень большие суммы (200-400 тысяч рублей), но быстро. За 2-4 месяца можно построить цепочку продаж, чтобы реинвестировать эти деньги под SEO.

В чем синергия процессов? Результаты, полученные при кластеризации в контексте, можно использовать при кластеризации в SEO. Не всё и не всегда будет одинаково, но многое можно взять из контекста для SEO.

Вывод: SEO и контекст скоро станут почти неразличимы, а экономия от их синергии растет.

Резюме

1) На начальном этапе более важен не сам сбор (всё автоматизировано), а поиск базисов;

2) Базисы могут быть простые и чистые (гироскутер) и мусорные и грязные (дизель);

3) Проверьте, все ли синонимы и переформулировки вы собрали: в помощь Wordstat и блок «похожие запросы» в SERP;

Собрав полное семантическое ядро, вы всегда получите конкурентное преимущество за счёт большего охвата аудитории и, следовательно, больше заказов, покупок, лидов.

В этой публикации я постарался изложить весь процесс начального сбора ключевых фраз — сервисы, программы, принципы поиска и работы с полученными данными. А так же, описан способ составления базового списка минус слов (на основе собранного семантического ядра), который исключит 95% всех не целевых показов!

Способ сбора универсальный и подойдёт не только для рекламной кампании в Яндекс Директ, но и для формирования полноценной семантики для поискового продвижения (SEO). Одно лишь отличие — собирая семантическое ядро для контекстной рекламы, обычно не уходят так глубоко в НЧ фразы. А методы фильтрации и составления списка минус слов — одинаковый.

1-ый шаг. Сбор маркерных слов для парсинга в Яндекс WordStat

Статью пишу на основе одной из последних моих работ — лыжное снаряжение, техника катания и т.д.

Для поиска маркерных слов используем:

- Сам сайт, его разделы с товарами или услугами;

- Сайты конкурентов. Анализируем внешне по разделам и услугам, так и с помощью сервисов — megaindex, key.so и тому подобных;

- Сервисы синонимов;

- Правая и левая колонка в Яндекс WordStat, блок «с этой фразой ищут» под поисковой выдачей.

Маркерные слова/словосочетания — это только направления для дальнейшего изучения, «копания» вглубь, так сказать . Если в список уже добавили фразу — «выбор лыж», то не надо добавлять вложенную «выбор горных лыж». Все вложенные фразы будут найдены после парсинга в Key Collector.

Главная задача — собрать максимум маркерных слов (направлений), проверить синонимы, сленговые слова и сформировать общий список, по которому будем «копать» дальше.

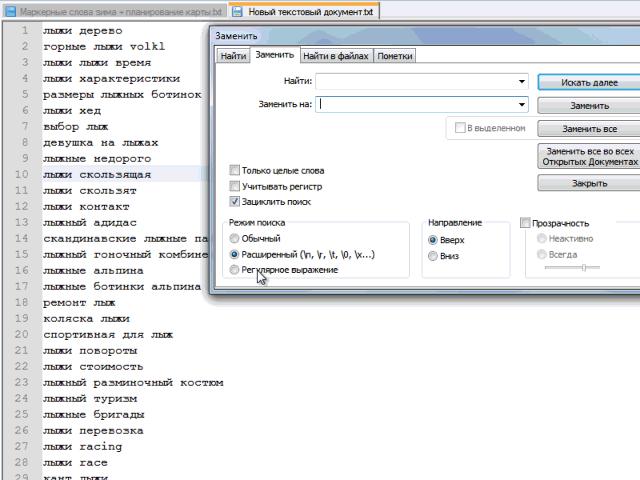

Формировать удобно в визуальном виде, к примеру в и выглядит вот так:

На скриншоте открыта только одна ветка, чтобы изображение было вменяемого размера.

Огромная польза от такой визуализации, лично для меня, что если раскрыть все направления, сразу понимаешь, что многозадачность надо выключать и работать только с одним разделом, а не сразу со всеми. А то с последовательностью действий иногда возникают проблемы.

Важно : Для быстрой обработки и сохранения ключевых слов в Wordstat, попробуйте бесплатное расширение для браузеров — Yandex Wordstat Assistant . С помощью него можно быстро переносить необходимые ключевые фразы в семантическое ядро.

Таблица с вопросами удобна для больших проектов. Не знаю, как её назвать профессионально, но через такие вопросы, можно существенно расширить семантическое ядро, найти новые интенты, о существовании которых даже не подозревал в начале.

Собранные фразы перемножаются, а затем проверяются на частотность в Wordstat. Частотные фразы добавляются для дальнейшего изучения.

Интент — это то, ради чего пользователь вводит запрос в поисковую систему. Можно сказать его «боль». Набор из ключевых фраз может объединяться по одному интенту, то есть быть вызванным одним мотивом, хотя при этом написание и набор слов могут различаться.

Надо ли платные сервисы и программы для сбора семантического ядра?

Я использую программу Кей коллектор и все ниже описанные действия провожу в нём. Если её нет, то собрать полное ядро вряд ли получится. Вы сможете, конечно, вручную «походить» по Wordstat, расширение Wordstat Assistant в этом сильно поможет, взять ещё фразы из бесплатных баз, вроде Букварикса. Но это всё будет малая часть того, что действительно можно собрать.

В некоторых ситуациях этого достаточно, хотя я сторонник создания максимально полной семантики, особенно если тематика сайта небольшая и тематического трафика мало. В таких случаях целесообразно собрать всё, чтобы максимально охватить свою нишу.

Если у вас один сайт, то выгоднее будет заказать услугу сбора семантического ядра на аутсорсе. Заплатите 3-5 тысяч рублей, но получите полное ядро с максимум ключевых фраз, без необходимости покупать софт, оплачивать сервисы и так далее.

Для Яндекс Директ ключевые фразы в Key Collector собираю редко, только когда большие рекламные кампании, много направлений... Для маленьких и средних ниш достаточно Wordstat и проработка синонимов.

Чаще всего директологи плохо разбираются в объекте рекламы, и если вы рекламируете ваш товар/услугу, то вы априори подберете правильные ключевые фразы и лучшие объявления, которые затронут необходимые струны вашей целевой аудитории. Вам только надо разобраться в некоторых тонкостях и последовательностях работы. Что я и постараюсь подробно описать в этом цикле статей.

2-ой шаг. Сбор ключевых фраз в Яндекс WordStat

Собранные маркерные слова пропускаем через левую колонку Wordstat в Key Collector.

Для экономии времени большие направления можно разбивать вот так ёлочкой:

Больше семи слова WordStat не показывает, поэтому в подобных запросах только семи словный шаблон.

Вордстат даёт возможность просмотреть только 2000 вложенных фраз. Это 40 страниц. Если пролистаете к 40-ой странице по фразе «лыжи», то увидите, что список заканчивается на выражении с частотностью 62 показа. Для полного семантического ядра этого будет мало, так как дальше ещё может быть несколько сотен низкочастотных фраз, которые могут приносить дополнительный трафик.

Метод «елочкой» позволит сократить время и не проводить повторную итерацию парсинга полученных ключевых фраз после первого сбора. Key Collector возьмёт все фразы с Wordstat по данному маркерному слову, вплоть до частотности в 1, не ограничиваясь стандартными двумя тысячами.

Сбор ключевых фраз конкурентов и базы

Используем сервис megaindex, key.so или serpstat.com. Желательно проработать 5-10 прямых конкурентов. Из бесплатных баз, могу посоветовать .

Наблюдение: если первоначально хорошо проработаны маркерные слова, синонимы, сленговые выражения, то Wordstat даёт 70-80% поисковых запросов, а оставшиеся добираются от конкурентов и букварикса.

Эти фразы не стоит мешать со всеми, а добавлять лучше в отдельную группу в кей коллекторе.

Обратите внимание, чтобы при добавлении стояла галочка «Не добавлять фразу, если она есть в любой другой группе»:

Этим ограничением недопустим добавление дублирующих фраз в общее семантическое ядро.

Букварикс — отдельная история. Очень много неявных дублей, запросы различаются только перестановкой слов. Находит много фраз, но 70-80% из них не подойдут нам. Добавляю в отдельную группу, но не вычищаю и не работаю с ней, а только ищу интересующие меня фразы поиском, чтобы посмотреть, можно ли чем дополнить основную семантику с него или нет.

Сбор поисковых подсказок

Как только собрали все фразы в WordStat и конкурентов, следует объединить их в мульти-группы , отсортировать по базовой частотности (обычно от 100, либо от 50 если ниша небольшая) и выбрать целевые фразы для сбора поисковых подсказок по ним:

GIF

Вторая итерация сбора фраз для семантического ядра

На данном этапе собрано почти всё :). Для полноценного ядра требуется заглянуть ещё глубже и посмотреть вложенные фразы для найденных фраз в ходе вышеописанных действий.

Для фраз, собранных методом «ёлочки» не надо проводить повторную итерацию сбора, а вот для запросов найденных у конкурентов, выбранных в буквариксе и поисковых подсказок — стоит.

Для повторной итерации я сортирую собранные фразы по базовой частотности и выбираю целевые (так как мы ещё не чистили стоп словами, не стоит выделять всё подряд) до значения частотности в 100 единиц. Заново запускаю по ним пакетный сбор из левой колонки Yandex WordStat .

Важно: не мешайте все повторные сборы вместе, создавайте отдельные группы для конкурентов, букварикса, основному ядра собранному по маркерным словам, парсинг по второй итерации и так далее. Чем подробнее вы раздробите в моменте сбора семантики, тем проще её будет чистить от нецелевых фраз. Объединить всегда успеете!

3-ий шаг. Удаляем нецелевые фразы

На данном этапе надо удалить явно не целевые запросы. Проделать это можно с помощью универсальных стоп-слов. Я собираю их в этом файле на Google Docs ..

Делим все слова на: целевые / нецелевые / сомневаюсь

Этот шаг нужен для создания общего списка минус фраз, который можно использовать сразу на всю рекламную кампанию и для чистки всей семантики от нецелевых поисковых запросов.

На выходе получаем список из целевых и стоп слов с помощью которых мы будем чистить и проверять семантическое ядро.

Я сторонник параноидального способа 🙂 , который занимает много времени, но способен исключить 95% всех не целевых ключевых фраз.

По опыту скажу, чем качественнее проработан список минус слов и фраз, тем меньше в Яндекс Директ проскакивают не целевые показы и показы по синонимам, которые так любит добавлять поисковик для кампаний новичков, которые не уделяют должного внимания этой процессу.

У вас будет чистейший трафик, так как мы все уникальные слова в семантике проверили в ручном режиме и определили их принадлежность.

Алгоритм действий:

1. Выгружаем весь список ключевых фраз в notepad.

2. Превращаем фразы в список слов. Их будет много, если брать мой пример с семантикой под лыжи, то около 60 тысяч.

Пример автоматической замены пробела на «перенос строки» в notepad:

GIF

Этот шаг некоторые делают в Word, еще какими-то программными средствами. Я для себя выбрал блокнот notepad . Главный плюс — минимум действий для получения желаемого результата.

3. Копируем все слова в Excel и удаляем дубли:

После удаления дублей, остаётся около 15-20% слов от общего количества.

Получен список всех уникальных слов в нашей семантике. Далее каждое слово я прохожу с вопросом: целевое / не целевое / сомневаюсь . У слов, которые явно целевые, ставлю 1 в соседней ячейке, у сомневающегося 2, у минус слов ничего не ставлю, так как их будет больше всего.

Все сомневающиеся слова проверяю на конкретных поисковых фразах в семантическом ядре (быстрый поиск кей коллектора).

На выходе получаем список целевых слов и минус-слов. После чего, можно отдохнуть и попробовать осмыслить весь процесс и понять описываемую последовательность.

Резюмирую статью

Использую слово итерация, чтобы были понятны проделываемые действия. А то слово «сбор» общее и легко запутаться, особенно новичку.

Сейчас вот задумался. Наверно зря я объединил описание процесса сбора семантики для SEO и Директа. По большому счёту, второй шаг c углублённым сбором абсолютно всех фраз, для контекста не нужен. Нам нужные только ВЧ и СЧ фразы (частотность от 100 и выше, но зависит от тематики) и самые целевые НЧ.

В любом случае, пункты под номером 1 и 3 абсолютно одинаковы для обоих видов работ.

В следующих публикациях мы начнём группировать и сегментировать ключевые фразы, а так же вычищать семантику от не целевых фраз, неявных дублей и всего того мусора, которого примерно 70-80% от собранного на данном этапе.

Подписывайтесь на обновления блога в

Соберем семантическое ядро для Яндекс Директа (для поисковых кампании и РСЯ)

Откуда будем брать ключевые слова? Каким должно быть семантическое ядро? Что с ним делать? Куда пихать, как разделять, что отправим в поисковую рекламную кампанию, а что в . Обо всем этом ниже.

Основы сбора семантического ядра для Директа

Перед сбором семантики уясним пару моментов (для тех, кто не знал), что для крутой и прибыльной рекламной кампании важен охват. Охват целевого, чистого трафика, разумеется. Для этого мы соберем как можно больше базовых масок ключей, пропарсим в Кейколлекторе (КК) и добавим некоторые фразы из специальных баз с ключевыми словами – ниже расскажу подробнее. Таким образом, у нас будет довольно полное семантическое ядро. Полнее, чем у 80% рекламодателей 🙂

Что такое базовые маски ключевых слов?

Это одно или два слова, которые описывают тематику (нишу) и на которых строится семантическое ядро для Яндекс Директ. Например, в Аренде спецтехники – «услуги спецтехники», «аренда спецтехники» – базовые маски, просто «спецтехника» – нет. Можете взять «спецтехнику» за базовую маску и пропарсить, но мусора будет много, нужных ключевых слов мало. Так же и в других сферах, в Отделке квартир – «ремонт квартир» – да, «квартира» – нет.

Расширяйте семантическое ядро транслитерацией

Транслитерация – пишем по-русски латиницей, например. Если, конечно, тематика предусматривает такие ключевики. Например, купить айфон – купить iphone, яндекс директ – yandex direct. Не применяйте транслитерацию на ровном месте, например – ремонт квартир – remont kvartir. Толку никакого не будет, такие запросы не вводят в поисковик, такая семантика будет пустой. Далее, пропарсив все в КК, увидите частотность и уберете пустые запросы, сделаете «рабочее» семантическое ядро для Директа.

Используйте синонимы при сборе семантики

Иногда мы не берем за базовую маску одиночное слово. Например, автомобиль, в тематике ремонт автомобиля. Появится столько мусора, что устанем минусовать мусор. В таком случае лучше поработать с синонимами (ремонт, отремонтировать, ремонтировать и тд.), чем создавать семантическое ядро через высокочастотные, мусорные однословники.

Где я ищу маски ключей и как расширяю семантическое ядро?

Сначала пишу из головы. И где нибудь на пятой маске (где–то тут фантазия часто заканчивается), пользуюсь следующей схемой:

1. Собираем маски из Wordstat. Иду в вордстат и вбиваю туда то, что написал из головы. После этого в вордстате открывается правая колонка (рисунок №1). В правой колонке вордстата показываются запросы, которые люди еще вводили и искали вместе с базовыми масками, которые я придумал вначале. По такой схеме, иногда я залипаю в вордстате на час, переходя по правым колонкам. Все маски ключей из вордстата я добавляю в Yandex Wordstat Assistant (рисунок №2) (YWA – расширение для Хрома, Яндекса, Оперы). YWA быстро формирует список из базовых масок и выделяет уже добавленные фразы при переключении по колонкам вордстата. Проще говоря, через YWA можно быстро накидать список масок из вордстата, не покинув браузера.

В правой колонке вордстата тоже можно найти базовые маски

Пробегаю по правым колонкам и собираю маски в YWA

2. Просматриваем поисковики. Перебираю маски ключей на выдачу в поисковых системах. Вбиваю фразы в поисковики и смотрю дискрипшены (рисунок №3) и смотрю Яндекс и Google картинки (рисунок №4) (там часто нахожу много нового).

Смотрим выдачу в Яндексе и Google

Просматриваем картинки в Яндекс и Google картинкам

3. SpyWords. Далее, сформированный список масок (по желанию) отправляем в SpyWords (SW). Если пользуетесь Кейколлектором (если нет – странно), то можно из него спарсить выдачу SW. SW прибавит масок ключей и синонимов. Будет много мусора, парсите SW в отдельную группу, заберете нужные маски, а группу удалите потом.

4. Парсим в Кейколлекторе. Теперь беру все маски ключей и заливаю в Кейколлектор. Чаще, 1 маску ключей помещаю в отдельную группу. 1 маска = 1 группа (рисунок №5). Так привык и такой подход не раз выручал. Если вдруг по какой–нибудь одной маске спарсите пару тысяч шлака, можно легко удалить шлаковую группу. А если парсить все маски в одну группу, будет весело. Либо заново все парсить, либо сидеть и судорожно вычищать мусор.

Вот так выглядит уже пропарсенное и очищенное семантическое ядро

5. Пропарсили маски в КК. Парсим подсказки. Я рекомендую собирать подсказки в отдельную группу (т.к. много мусора) и по опыту – выбирайте подсказки Yandex и Mail.ru. Если очень хочется – еще Google, но в отдельную группу его, там еще больше мусора, чем в подсказках Яндекса и Майл.ру.

6. Чистим ключи. На этом этапе чищу ключевые слова от мусора. О чистке, минусации слов написал .

7. Добираем ключи из баз. Затем идем и добираем фразы из специальных баз. Самые популярные (вроде) – База пастухова, MOAB, Букварикс. Рекомендую использовать Букварикс. На сколько знаю, в Буквариксе меньше «мусора» и пока еще бесплатный. Сделайте для них отдельную группу в КК и парсите, потом отминусуете ненужные ключи.

Все, семантическое ядро собрано и очищено. Осталось разгруппировать.

Семантика для Яндекс Директа отличается в поисковой кампании и кампании для РСЯ

Семантическое ядро для РСЯ

На данном этапе (пока ничего не разгруппировано), удобнее сделать семантику для РСЯ. Фильтруете в КК базовую частоту больше 50 запросов и забираете ключевые слова для настройки РСЯ. Семантику с частотностью меньше 50 в месяц нет смысла брать в РСЯ. Трафика с таких ключевых слов вы вряд ли получите. Раньше я фильтровал ключи для РСЯ еще по количеству слов (3 и меньше). Забил, когда увидел, что и 4-5 словники конвертят.

Семантическое ядро для поисковых рекламных кампаний Директа

Тут я беру семантику (уже очищенную от мусора), удаляю пустые ключевые слова, с нулевой частотностью и делаю группировку. Группировка ключевиков – второй по важности момент в семантике для Директа, после сбора масок ключей.

Для чего нужна группировка ключевых слов?

Группировка ключевиков стала более актуальной в Директе с приходом статуса «Мало показов» , когда все низкочастотные группы ключевых перестали участвовать в аукционе. И поэтому сейчас группировка семантики важна еще тем, что просто нужно сохранить охват в Директе. Группировку ключевых слов мы делаем для большей эффективности рекламных кампаний. Чтобы сделать цену клика немного пониже, из-за хорошего CTR. В конечно счете, чтобы получать больше звонков, заказов при том же бюджете (понятно, что не один Директ влияет на цену заявки).

Самая распространенная группировка ключей – деление семантического ядра на горячие, теплые, холодные ключевые слова.

По факту – холодные ключи, это обычно околоцелевые и конвертят они чуть хуже, чем никак. Чтобы там ни говорили продавцы шашлыков (или септиков?) кто в теме, тот понимает о чем я 🙂 У кого конвертят – молодцы.

Я делаю семантическое ядро на горячие и теплые ключи для поисковой рекламы Директа

«Горячесть» ключей для каждой тематике своя.

Горячие ключевые слова:

В товарах – это приставки «купить», «цена», «доставка», какие то точные характеристики товара, принадлежность товара к какому то гео. Например «кирпич саратов», «кирпич купить» и тд.

В услугах – «заказать», «заказ», «под ключ», так же принадлежность к гео. Например, «заказать портрет а4 карандаш», «ремонт квартиры под ключ» и тд.

Теплые ключевые слова – это слова, в которых нет явного намерения приобрести, заказать товары (услуги), но это слова из нашей тематики и очень вероятно, что по ним будут конверсии. Например, «силикатный кирпич», «кладка кирпича», «портрет карандаш» и тд. Понятно, что ключевые слова мы корректируем минус словами и часто «теплые ключевые слова» конвертируют не хуже «горячих».

Я бы сказал, что это условное разделение. Чтобы на разгруппированную семантику потом релевантные объявления написать и анализировать проще, когда каждая группа объявлений подписана и мы знаем какие там ключи внутри.

Этой информации достаточно, чтобы собрать хорошее семантическое ядро для Директа (при условии, что Excel и Кейколлектор у вас есть).

Пишите в комменты или по контактам, если какие–то моменты непонятны.